数据预处理的核心流程与关键步骤解析

数据预处理是数据分析与挖掘的基石,其质量直接决定了后续模型的性能与结果的可靠性。一个完整的数据预处理流程旨在将原始、杂乱、不完整的数据转化为干净、一致、适用于分析的标准化数据集。通常,数据预处理包含以下几个核心流程:

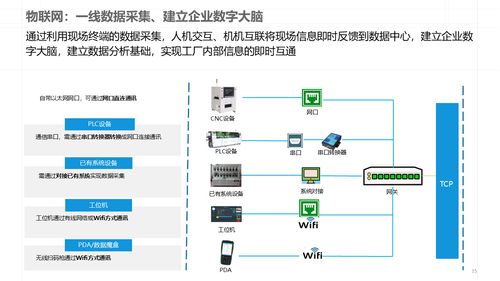

1. 数据收集与获取

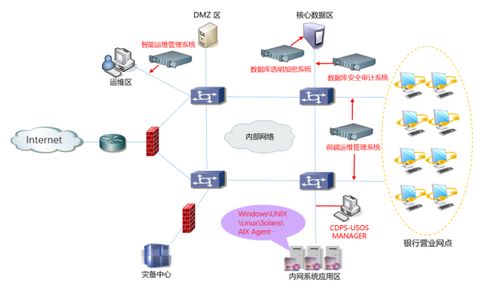

这是流程的起点。数据可能来自数据库、API接口、日志文件、传感器、调查问卷等多种异构源。明确分析目标,并据此收集相关数据是第一步。

2. 数据清洗

这是预处理中最关键、最耗时的环节,旨在处理数据中的“脏数据”。主要包括:

- 处理缺失值:根据情况选择删除缺失记录、用均值/中位数/众数填充,或使用插值、模型预测等更复杂的方法。

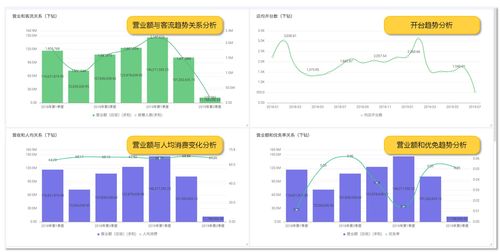

- 处理异常值:识别并处理偏离正常范围的数值。可通过箱线图、3σ原则等方法检测,并根据业务逻辑决定是修正、删除还是保留。

- 纠正不一致数据:统一格式、单位、编码(例如将“男/女”统一为“M/F”),解决拼写错误和重复记录。

3. 数据集成与转换

数据集成:将来自多个数据源的数据合并,形成一个一致的数据存储。需处理实体识别、属性冗余和值冲突等问题。

数据转换:将数据转换为适合建模的形式。常见操作包括:

* 规范化/标准化:消除不同特征间的量纲影响,如最小-最大规范化、Z-score标准化。

- 数据离散化:将连续数据分段为分类数据(如年龄分段为“青年”、“中年”)。

- 特征构造:基于现有特征创建新的、更具预测能力的特征(如从日期中提取“星期几”、“是否节假日”)。

4. 数据归约与降维

在尽可能保持数据原貌的前提下,降低数据规模,提升处理效率。方法包括:

- 特征选择:从原始特征中筛选出最相关、最重要的子集。

- 维度约减:使用主成分分析(PCA)等方法,将高维数据投影到低维空间。

- 数据抽样:在数据量极大时,使用有效的抽样方法获得代表性样本。

5. 数据格式化与存储

将处理好的数据转换为最终分析系统或模型所需的特定格式(如CSV、数据库表、特定框架的Tensor等),并进行持久化存储,供后续阶段直接调用。

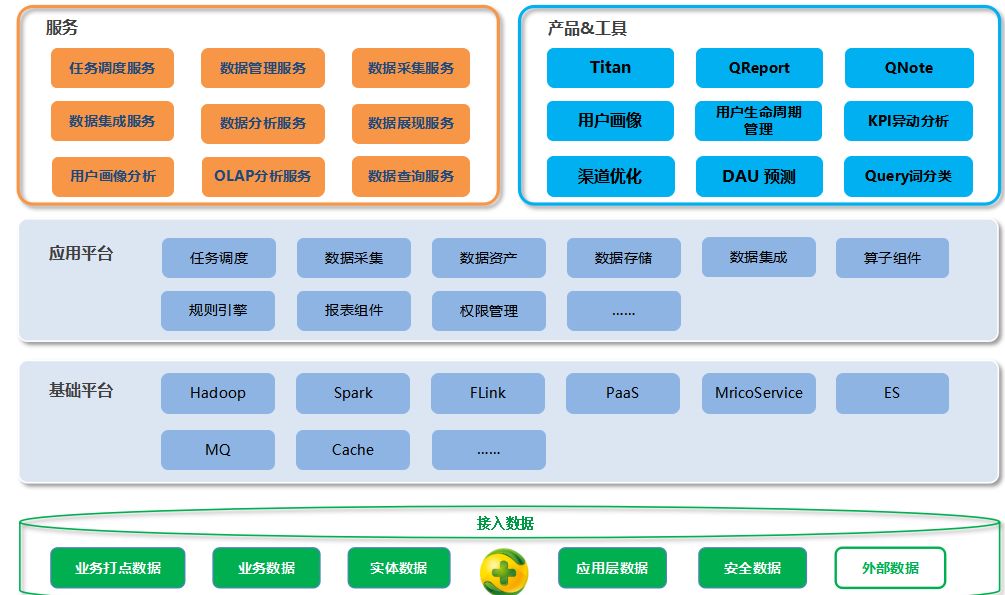

而言,数据预处理是一个系统性的工程,各步骤之间并非完全线性,可能需要迭代进行。以亿信华辰等专业数据服务商提供的数据处理服务为例,其价值在于能够借助成熟的平台和专家经验,将上述流程自动化、标准化和规模化,确保数据在进入核心分析或应用前的“健康度”,从而为数据驱动决策奠定坚实基础。

如若转载,请注明出处:http://www.zhihongsite.com/product/54.html

更新时间:2026-02-27 22:07:21